TinyMLとは?基本概念や実装方法を解説

はじめに

近年、IoTデバイスやエッジコンピューティングの普及に伴い省電力な環境で効率的にデータを処理する技術が求められるようになり、TinyML(タイニーマシンラーニング、タイニーエムエル)への注目が高まってきています。TinyMLは、リソースが限られた組み込みデバイスで機械学習を実行できる技術で、リアルタイムでデータを処理することもできます。このコラムでは、TinyMLの基本概念からその実装方法、活用事例をご紹介します。

TinyMLの基本概念と特徴

TinyMLは、極めて小さなデバイス上で機械学習を実行する技術であり、その名の通り「Tiny(小さな)」と「ML(機械学習)」を組み合わせたものです。TinyMLは、非常にリソースが限られたデバイスで機械学習を行うことに特化しており、小型で軽量なモデルを使用します。通常、クラウド上に実現される大規模機械学習(例えばLLM)は大量のデータ処理能力や電力を必要としますが、TinyMLはその逆で、数十キロバイトのRAMや数ミリワットの電力で動作します。これにより、センサーやマイクロコントローラのようなリソース制約のある小型デバイスでも機械学習を利用することができるようになります。

TinyMLにおける重要な技術の1つは、モデルの軽量化と最適化です。通常、モデルは精度とサイズのバランスを考慮して設計されますが、TinyMLでは特にサイズと消費電力が重視されています。このため、モデルのサイズを小さくするために、量子化、枝刈り(プルーニング)、知識蒸留(蒸留)の技術が多く活用されています。量子化は、モデルの精度をある程度犠牲にする代わりに、計算時間とメモリ使用量を削減する方法です。枝刈りは、重要でない重みを削除することでモデルのサイズを縮小する技法です。知識蒸留は、より複雑で大きな学習済みモデルを、より小さいモデルで近似する(知識を継承する)技法です。

TinyMLにはリアルタイムでデータを処理する能力があり、データ処理の遅延を最小限に抑えることができます。クラウドに頼ることなくデバイスの中で機械学習を実行できるので、通信の遅延も気にする必要がありません。そのため、ネットワークから切り離されたデバイス上で動作するリアルタイムに応答が必要なアプリケーションに適しています。TinyMLは、エッジコンピューティングの中で新たな可能性を広げる技術として、今後の成長が期待されています。

\ 資料をご用意しています /

エッジ領域におけるTinyMLの役割

エッジ領域で動作するAI・機械学習は、データ処理の中心をクラウドからエッジデバイスにシフトさせる可能性があります。エッジ領域でデータを処理することで、通信の遅延やコスト、接続が安定しない環境や帯域幅が狭いネットワークを気にする必要がありません。また、エッジ領域のAI・機械学習はプライバシーの向上にも貢献します。データがエッジデバイス内で処理されるため、個人データや機器の稼働状況がクラウドに送信されるリスクを軽減し、ユーザーのプライバシー保護を強化します。これにより、セキュリティが求められるヘルスケアや金融などの分野でも安心してAI・機械学習を導入できます。

近年、エッジAIはより強力なハードウェアを利用してデータ処理を行うようになり、より複雑で大きなモデルを扱うことができるようになっています。エッジAIの高性能化が著しくクラウドAIとの違いが小さくなる中、組み込みデバイス上の機械学習との役割分担や適用範囲、開発環境や技術的な違いなどを区別する必要がでてきました。そのような状況の中、エッジAIとは異なるものとして「TinyML」が注目されるようになってきています。

エッジ領域におけるTinyMLでは、エッジAIと同様に通信による遅延やコスト、プライバシーの問題が生じません。一方で、エッジAIがより包括的、多目的なモデルを提供するのに対し、TinyMLは局所的で単一の目的のために利用されます。エッジAIでの計算量が増える傾向なのに対し、TinyMLは計算量を抑えてリアルタイムに応答します。エッジAIが高性能化と引き換えに電力を必要とするのに対して、TinyMLはエネルギー効率の向上を可能にしてバッテリー駆動のデバイスでも長時間稼働させることができます。このように、TinyMLはエッジ領域で、プライバシー保護、明確な目的と機能、応答速度、エネルギー効率といった多方面でメリットがあり、次世代の社会で活躍するスマートデバイスの進化を支える基盤となっています。

TinyMLの実装方法

少しですが技術的なところにも触れておきます。

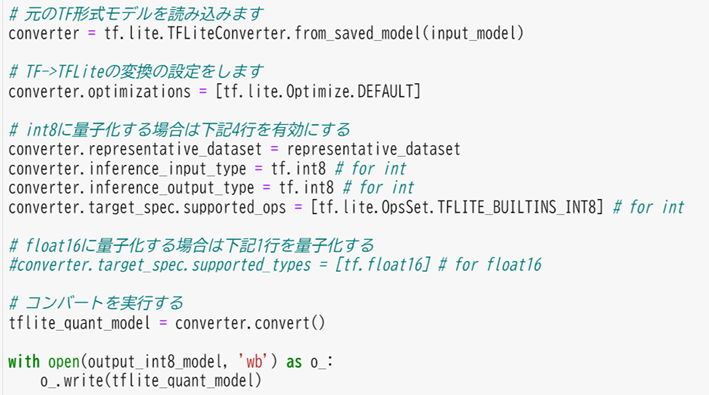

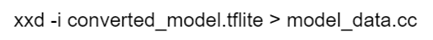

TinyMLの中でも代表的なフレームワークであるTensorFlow Lite for Microcontrollers(以降TFMicro)(※1)を用いたモデルの実装方法を示します。

※1 TensorFlow Lite for Microcontrollers(https://www.tensorflow.org/lite/microcontrollers?hl=ja(外部サイト))

※2 TensorFlow Lite(https://www.tensorflow.org/lite/guide?hl=ja(外部サイト))

※注意点

TFMicroでのモデル実装には注意点が存在します。

TinyMLの実装環境

TensorFlowとTFMicroではモデル設計は共通ですが、その他の工程では多くの違いがあります。中でも、マイコンでモデルを動作させるには、それぞれの環境へのデプロイが必要となります。せっかくPythonで良いモデルが設計できても、マイコンへのデプロイで途方に暮れることもあるでしょう。

その点、STマイクロ社のNanoEdge AI Studio(※3)はツール上でデータ加工~デプロイまでを完結してくれるためTinyMLへの参入は比較的容易です。加えて、STマイクロ社は独自のモデルを実装したい場合に向けて、STM32Cube.AI(※4)というツールも提供しています。STマイクロ社のマイコンに限定されてしまいますが、同社のマイコンを採用する際は有力な選択肢となります。その他にも、例えばNuvoton社(※5)もマイコン向けのAI開発環境としてTFMicroのサンプルプロジェクトを公開しています。

※3 NanoEdge AI Studio - STMicroelectronics - STM32 AI(https://stm32ai.st.com/ja/nanoedge-ai/(外部サイト))

※4 STM32Cube.AI - STMicroelectronics - STM32 AI(https://stm32ai.st.com/ja/stm32-cube-ai/(外部サイト))

※5 Nuvoton AI - Homepage - Nuvoton AI(https://www.nuvoton.com/ai(外部サイト))

| 項目 | TensorFlow Lite for Microcontrollers |

NanoEdge AI Studio |

|---|---|---|

| 提供 | STマイクロエレクトロニクス | |

| 費用 | Apache Licence 2.0 | 完全無償 |

| 開発言語 | C/C++ | C |

| 動作対象 | 特になし | ST Microのマイコンのみが対象 |

| データ加工 | ユーザー | ツール自動 |

| モデル作成 | ユーザー | ツール自動 |

| フレームワークポーティング | ユーザー | ツール自動 |

| 備考 | データ加工、モデル設計もユーザー自身で行う必要があります。複雑なモデルや特殊なデータを扱う際は、本フレームワークの高い柔軟性が大いに役立つことでしょう。 | AutoMLなのでデータ加工、モデル選択、パラメータチューニング、デプロイまで本ツールのみで完結します。モデルの候補も多数準備されています。目的に合致するモデルがあれば有力な選択肢となるでしょう。 |

TinyMLの活用事例

さまざまな分野で、TinyMLの新しいアイデアや活用方法が広がっています。

例えば、農業分野では、環境センサーを使って土壌の温度や湿度、気温をリアルタイムで監視し、作物の成長を最適化するシステムが開発されています。これにより、農業生産性の向上と資源の効率的な利用が可能となります。

また、ヘルスケア分野では、ウェアラブルデバイスにTinyMLを組み込むことで、心拍や活動量を監視して個人の健康状態を評価するために使われています。これにより、健康に関する問題をいち早く発見し、適切な対応ができるようになります。

スマートホームやスマートシティの分野では、エネルギー消費の最適化や、見守り・防犯といった安全性の向上を目的としたシステムが導入されており、これらのシステムでは、小型で省電力のTinyMLデバイスが重要な役割を果たしています。

TinyMLには小型で省電力なデバイスで機械学習を実行できるという特徴があります。この特徴を活用することで、さまざまな分野において今までできなかった新しいソリューションの提供や技術革新が進められています。

まとめ

TinyMLは、電力消費や通信コストの削減、リアルタイムでのデータ処理など、現代のデジタル社会で直面するさまざまな問題を解決できる可能性を持っています。本コラムを通じてTinyMLの可能性を感じ、自身のプロジェクトにどのように取り入れられるかを検討いただければ幸いです。

\ 資料をご用意しています /

2025年5月14日公開

※この記事に掲載されている内容、および製品仕様、所属情報(会社名・部署名)は公開当時のものです。予告なく変更される場合がありますので、あらかじめご了承ください。

関連記事一覧

【初学者向け】研修で得られるものとは【セキュリティー】

【初学者向け】研修で得られるものとは【セキュリティー】 Black Hat発表から学ぶ!フィッシング詐欺とアカウント復旧の新たな課題

Black Hat発表から学ぶ!フィッシング詐欺とアカウント復旧の新たな課題 MBSEとは?ドキュメントベースの開発の違いやメリット、期待される効果について解説

MBSEとは?ドキュメントベースの開発の違いやメリット、期待される効果について解説 工場の制御システムを守るためのセキュリティ対策ガイド

工場の制御システムを守るためのセキュリティ対策ガイド 【脅威分析・TVRA】効果的なセキュリティリスク評価のステップ

【脅威分析・TVRA】効果的なセキュリティリスク評価のステップ IoTセキュリティガイドラインとは?目的や概略、推奨されるセキュリティ対策を解説

IoTセキュリティガイドラインとは?目的や概略、推奨されるセキュリティ対策を解説 セキュリティ要件適合評価及びラベリング制度(JC-STAR)とは?概要や評価基準を解説

セキュリティ要件適合評価及びラベリング制度(JC-STAR)とは?概要や評価基準を解説 製造業がMBSEを導入する前に知るべき課題と対策

製造業がMBSEを導入する前に知るべき課題と対策 複雑化する開発にMBSEを。いまこそ導入すべき3つの理由

複雑化する開発にMBSEを。いまこそ導入すべき3つの理由 エッジAIとTinyMLが切り開く可能性

エッジAIとTinyMLが切り開く可能性 時系列分析について実際のデータを例にモデルや活用事例をご紹介

時系列分析について実際のデータを例にモデルや活用事例をご紹介 エッジAIとは?活用事例や導入方法、メリット・デメリットを解説

エッジAIとは?活用事例や導入方法、メリット・デメリットを解説 IoTのセキュリティ対策とは?3つのセキュリティリスクとその対応策

IoTのセキュリティ対策とは?3つのセキュリティリスクとその対応策